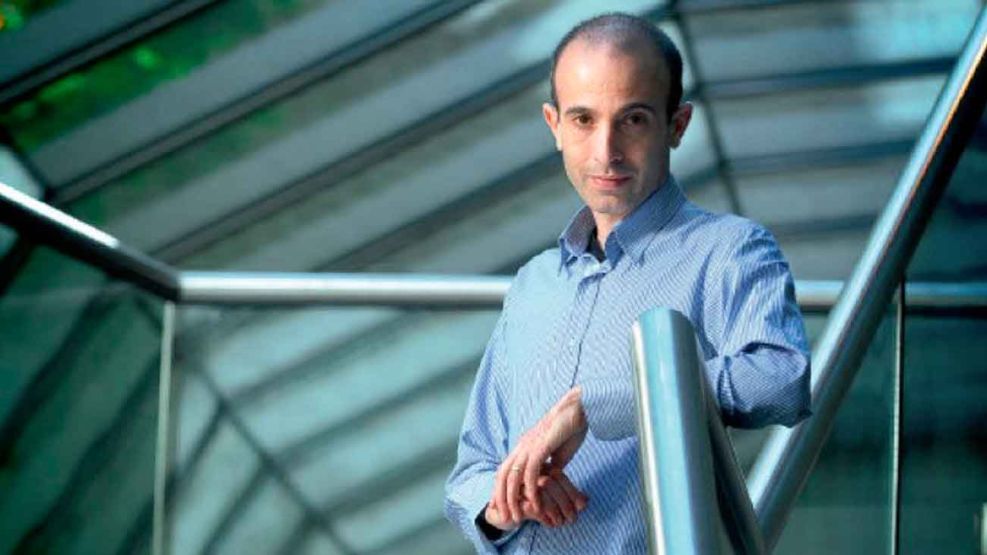

Según el profesor de historia Yuval Harari, el ChatGPT –la herramienta de inteligencia artificial generativa– representa un riesgo para la humanidad. Las advertencias de Harari se basan en la construcción de un escenario alimentado por la ciencia ficción hollywoodense, en el que las máquinas se vuelven contra los humanos.

En un punto, ChatGPT y Harari se asemejan: ambos alucinan cuando no saben qué decir. El primero inventa datos como resultado de una “laguna” de información y este término técnico se llama alucinación. El historiador ve robots asesinos incendiando las calles, alucinando que la ciencia ficción no es ficción.

En un artículo reciente publicado en el New York Times, el profesor de historia analiza la inteligencia artificial junto a dos ejecutivos de una ONG que promueve el uso responsable de la tecnología llamada Center for Human Technology. Esta organización propone una serie de consignas sobre la adopción de las nuevas tecnologías. Entre otras, está el “uso responsable” de la inteligencia artificial. Esto es obviamente encomiable, además de vacuo y tribunero. La realidad es que no queda claro realmente qué proponen más allá de predecir escenarios catastróficos como resultado de la evolución tecnológica.

El artículo critica la inteligencia artificial, como si fuera algo realmente nuevo, y propone una moratoria o pausa en la investigación.

Ante un escenario en el que las máquinas se volverían contra la humanidad, los pronósticos de estos tres coautores se suman a siglos de vaticinios similares, incluyendo la teoría heliocéntrica, la mecanización industrial y la aparición de los televisores. Sin embargo, las lagunas argumentativas de estos redactores no tienen conexión con la realidad. Ya que la lógica es comparable a la actitud de los escualos en Tiburón, buen cine. Ficción y nada más. En el mundo real, ni las computadoras ni los animales marinos quieren terminar con la humanidad.

El primer punto es que la inteligencia artificial generativa no tiene superhabilidades. De hecho, la realidad indica que ChatGPT se volvió menos astuto cuanto más interactuó con la gente, sorpresa que pocos tienen en cuenta.

Según el experto en inteligencia artificial Eliezer Yudkowsky, el ChatGPT era sobresaliente en cálculo de probabilidades, sin embargo, a medida que la herramienta aprendió de humanos, empeoró su estadística. O sea, cuanto más conoce a la gente, se convierte en menos inteligente. Y más allá de las habilidades propias de una máquina, como el cálculo; está la realidad de fondo.

Esta desinteligencia artificial, además, no siente, no desea, no nace ni muere. No tiene motivo para matarnos o defendernos. No sufre como un humano, por ende, no puede tener conciencia. No vive pensando que morirá, por ende, el paso del tiempo –y su demostración en el proceso de envejecimiento– no la afecta.

Los humanos estamos motivados por sufrimiento y nuestra eventual e inexorable muerte, sin afecciones no habría ni ciencias de la salud, ni pensamiento económico, ni ideas políticas.

En suma, no tiene la ambición de un dictador.

Harari, otra vez, se montó sobre un trending topic con desinformación. Ahora, aprovechó el miedo a lo nuevo. Posiciones como esas solo van a hacer que la gente pase dificultades para ingresar a la tecnología, pero no frenará su uso.

Harari como historiador sabe que siempre se perdió la batalla contra el progreso. Afortunadamente, esta no será la excepción.

*Analista en geopolítica. Filósofo y abogado especializado en antropología de la Universidad Temple de Filadelfia.