“Inteligencia Artificial (AI, siglas en inglés) por la gente, para la gente. Diseño e implementación de soluciones utilizando inteligencia colectiva y tecnología aumentada. (…) Somos una empresa de constructores que se preocupan profundamente por las implicaciones y aplicaciones del mundo real. No tenemos miedo de ir en contra de las normas establecidas y explorar la creatividad”. Con esta supuesta bondad de intenciones, se presenta en su página web Stability AI (stability.ai), que agrupa a un extenso laboratorio de algoritmos innovadores en distintas áreas, como imagen, lenguaje, audio, video, 3D y biología.

La noticia es que, en la tercera semana del nuevo año, la empresa detrás de este gigante del desarrollo de software y dos empresas más que ofrecen el uso de dicha tecnología fueron demandadas judicialmente por el uso indebido de imágenes con derechos de autor. Una, en Estados Unidos, implica a tres artistas: las norteamericanas Sarah Andersen y Kelly McKernan, junto a Karla Ortiz, de Puerto Rico. La otra en Gran Bretaña, presentada por el banco de imágenes Getty Images. La primera incluye a las plataformas Stable Diffusion (stablediffusionweb.com), que pertenece a Stability AI, Midjourney (midjourney.com) y DreamUp (dreamup.com). Mientras que la de Getty Images va contra la madre del problema: Stability AI.

¿Pero qué hacen con las imágenes? ¿Las ofrecen en su sitio web? ¿Las utilizan en exposiciones o publicaciones? No. Es habitual en académicos de dudoso prestigio el uso de la muletilla “es más complejo” para no explicar algo. Como ni este cronista ni los lectores de PERFIL aceptan eufemismos para evadir el conocimiento, trataremos de encontrar las causas de este leading case de la cultura.

“Stable Diffusion (perteneciente a Stability AI) contiene copias no autorizadas de millones de imágenes con derechos de autor.

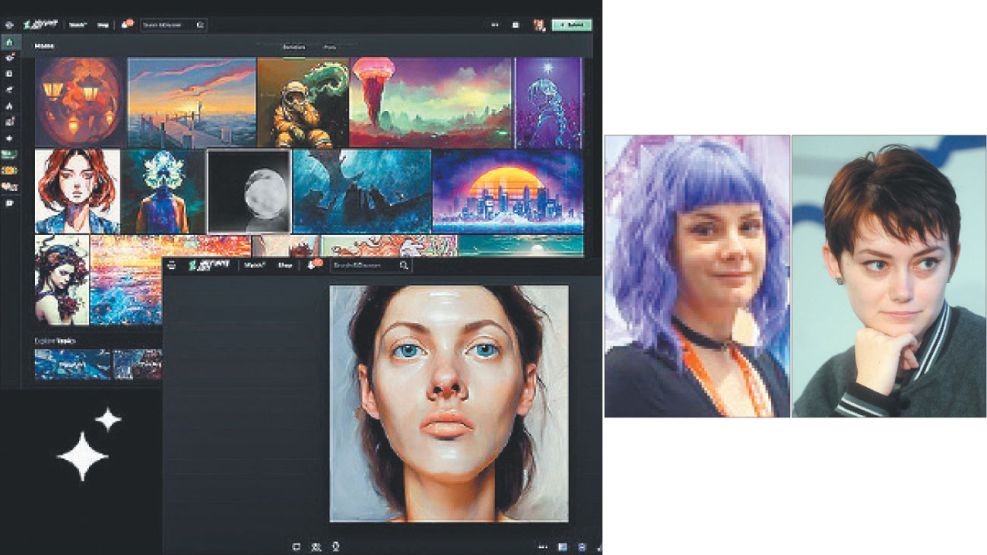

Copias realizadas sin el consentimiento de los artistas. Suponiendo daños nominales de US$ 1 por imagen, el valor de esta apropiación rondaría los US$ 5 mil millones. (En comparación, el robo de arte más grande de la historia en 1990 –13 obras de arte del Museo Gardner– fue por un valor actual de US$ 500 millones)”. Así explica la dimensión económica el abogado Matthew Butterick, en su blog stablediffusionlitigation.com. Allí también expone cómo opera este sistema para brindar una imagen (foto, dibujo, pintura, ilustración 3D) a partir de palabras claves. Por ejemplo, si visitamos las páginas web mencionadas, alcanzará con escribir “caballo en las montañas” en el sector de prueba de la misma, y al cabo de unos segundos aparecerán cuatro imágenes de caballos con estilos distintos.

Esto no es un milagro del software. La inteligencia artificial utiliza el aprendizaje y con él la memoria acumulativa en la comprensión de rasgos distintivos en imágenes. Una de las formas es la “difusión”, proceso matemático que almacena copias comprimidas de imágenes leídas como de entrenamiento. La difusión es un ida y vuelta en la compresión, con el agregado de “ruido” aleatorio.

En 2020, investigadores de UC Berkeley mejoraron esta técnica. Mostraron cómo la difusión podía almacenar imágenes en formato más comprimido sin afectar su capacidad para reconstruir copias de alta fidelidad. Estas se conocen como imágenes latentes que, además, pueden combinarse para producir nuevas. Stable Diffusion convierte las imágenes de entrenamiento en latentes mediante un codificador automático variacional (o VAE), así se modelan como puntos en un espacio multidimensional llamado espacio latente.

Los de Berkeley también aplicaron la idea de manejar la difusión con un modelo de AI llamado U-Net, inventado por investigadores biomédicos de Alemania en 2015. En 2022, investigadores de Munich mejoraron aun más esto: descubrieron cómo dar forma al proceso de eliminación de ruido con información adicional. Este proceso se llama condicionamiento. La herramienta para ello son las descripciones breves de texto, también conocidas como indicaciones, que describen elementos de la imagen.

Pero esta interfaz crea una capa de desvío “mágico” que hace difícil obtener copias obvias de imágenes de entrenamiento. No obstante, debido a que toda la información visual del sistema deriva de las imágenes protegidas por derechos de autor, las imágenes producidas, sin importar su apariencia, son necesariamente obras derivadas de las protegidas.

Según Business Insider, un representante de Stable Diffusion declaró que las “acusaciones de los artistas representan un malentendido sobre cómo funcionan nuestra tecnología y la ley”. En sí, se trata de un litigio contra el muñeco maldito y fantasma, tal vez el Chucky o verdadero Terminator, de la historia del arte.