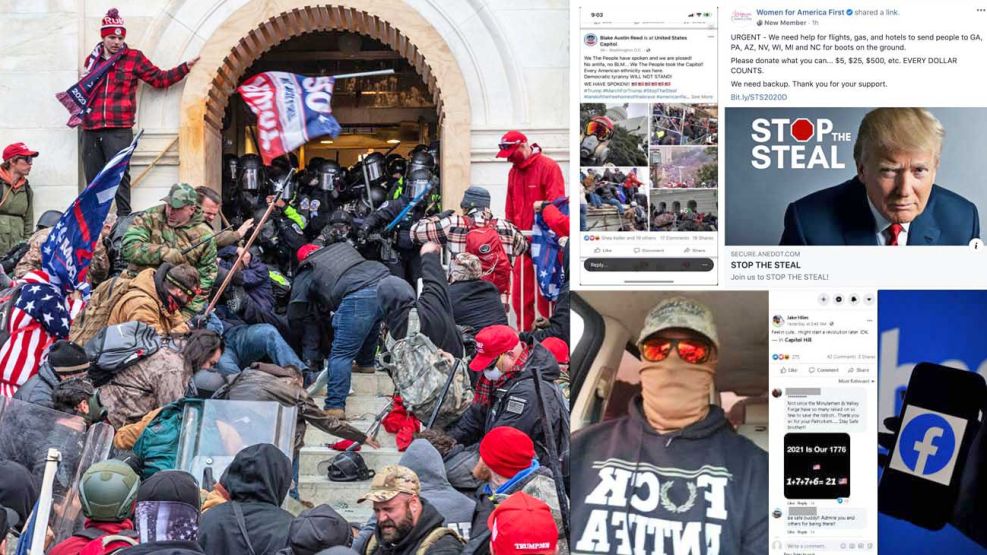

Mientras el Capitolio, en Washington, sufría el ataque de una turba de seguidores de Donald Trump, el 6 de enero, la red social más grande del mundo, Facebook, vivía una insurrección tan revulsiva a miles de kilómetros de distancia, en California, con cientos de empleados furiosos por el papel de la plataforma en la construcción del clima que llevó a esa violencia y hasta en su organización.

Al mismo tiempo que se desarrollaba el asalto a la sede del Congreso norteamericano, los ingenieros de Facebook ajustaban los controles internos para frenar la propagación de desinformación y contenidos incitadores, conscientes del rol jugado por la red en toda la situación.

Se decidió entonces, en forma emergencial, vetar a Trump en Facebook, suspender los comentarios en los grupos con antecedentes de discursos de odio, filtrar el lema “Stop the Steal” (Paren el robo), utilizado por sus seguidores y por el propio presidente para negar el resultado de las elecciones y etiquetar a Estados Unidos como “lugar de alto riesgo temporal” por violencia política.

Esos esfuerzos se desarrollaban en un clima interno de creciente frustración entre los empleados de Facebook, que veían una respuesta vacilante de la empresa al aumento del extremismo en Estados Unidos.

“¿No hemos tenido tiempo suficiente para averiguar cómo gestionar el discurso sin permitir la violencia?”, escribió un empleado en un tablero de mensajes interno mientras las cámaras de televisión mostraban a todo el mundo los disturbios del 6 de enero. “Hemos estado alimentando este fuego durante mucho tiempo y no debería sorprendernos que ahora esté fuera de control”.

Informantes. Es una pregunta que todavía pende sobre la compañía hoy, mientras el Congreso y los reguladores investigan el rol de Facebook en los disturbios del 6 de enero. Ahora apareció un nuevo “topo”, ex empleado, que acusa a la red social de Mark Zuckerberg de haber permitido la propagación del odio y la desinformación con fines de lucro.

Algunos documentos entregados a las autoridades estadounidenses revelan las alarmas de los empleados ignoradas y sobre todo decisiones de la empresa sobre la difusión generalizada de contenidos peligrosos, con el objetivo de polarizar la opinión pública antes y después de las elecciones presidenciales de noviembre de 2020.

Las nuevas acusaciones hechas contra Facebook están en línea con las formuladas por Frances Haugen, la ex empleada de la empresa que también testificó en el Congreso de los Estados Unidos. La red social, según la acusación del segundo “topo”, se ha negado reiteradamente a aplicar las normas de seguridad vigentes para todos los “amigos” de Facebook a Donald Trump y sus aliados, por temor a enfurecerlos y, en consecuencia, pagar un precio en términos de crecimiento de la empresa.

Los documentos internos proporcionados por los dos ex empleados sugieren que la empresa fue sorprendida por el estallido de la violencia. Rápidamente quedó claro que, incluso después de años de haber sido investigada por la poca vigilancia que aplicaba a los contenidos de los posteos, pasó por alto cómo los trumpistas prometían en Facebook que impedirían que el Congreso certificara la victoria de Joe Biden, lo que intentaron hacer ese día.

Los documentos también parecen reforzar la afirmación de Haugen de que Facebook antepuso su crecimiento y sus ganancias a la seguridad pública, lo que permite inferir que sus dos objetivos declarados -salvaguardar su negocio y proteger la democracia- se volvieron contradictorios en esos días.

Después del asalto, como surge del testimonio de Haugen, Facebook volvió a apelar a una serie de medidas de control para frenar la difusión de contenidos peligrosos o violentos, que ya había utilizado durante la campaña electoral de 2020, pero que desactivo en su mayoría después de los comicios. “En cuanto las elecciones concluyeron, las volvieron a desactivar o cambiaron la configuración a lo que era antes, para priorizar el crecimiento sobre la seguridad”, afirmó Haugen.

De hecho, los datos recopilados por un empleado de Facebook revelaron que en la semana siguiente a las elecciones estadounidenses, el 10% del contenido político visto en Estados Unidos no eran más que publicaciones sobre fraude electoral.

Un informe interno de Facebook posterior al 6 de enero –reportado previamente por BuzzFeed– reprochaba a la compañía por tener un enfoque “poco sistemático” ante el rápido crecimiento de las páginas “Stop the Steal”, las fuentes de desinformación relacionadas y los comentarios violentos e incendiarios.

Oficialmente, la compañía destaca que calibra cuidadosamente sus controles para reaccionar rápidamente a los picos de contenido de odio y violencia, como hizo el 6 de enero y, al mismo tiempo que sostiene que no es responsable de las acciones de los agresores, destaca que tener controles más estrictos antes de ese día no habría evitado lo que pasó.

Facebook cambiará su nombre para refrescar su imagen y generar "un metaverso"

La vocera de Facebook, Dani Lever, subrayó que las decisiones de la plataforma de aplicar o eliminar medidas de seguridad en aquel momento se basaron en sus propios monitoreos y en información de las fuerzas del orden. “Cuando esas señales cambiaron, también lo hicieron las medidas”, apuntó, y detalló que algunas de las medidas se mantuvieron hasta bien entrado el mes de febrero y que otras siguen activas en la actualidad.

“Partes interesadas”. Algunos empleados estaban descontentos con la gestión de contenidos problemáticos por parte de Facebook incluso antes de los disturbios. Una persona que abandonó la empresa en 2020 dejó una larga nota en la que denunciaba que las herramientas nuevas y prometedoras de control, respaldadas por investigaciones sólidas, estaban siendo limitadas por la propia empresa, por “miedo a las respuestas del público y de las partes interesadas en la política” (es decir, preocupación por las reacciones negativas de los aliados de Trump y de los inversionistas).

“Del mismo modo (aunque todavía más preocupante), he visto que se han retirado salvaguardas ya desarrolladas y en funcionamiento por las mismas razones’’, escribió el empleado, cuyo nombre fue tachado en el escrito presentado ante el Congreso.

Investigaciones realizadas por Facebook bastante antes de la campaña de 2020 dejaron pocas dudas de que su algoritmo podía representar un serio peligro de propagar desinformación y posiblemente radicalizar a los usuarios.

Un estudio de 2019, titulado: “El viaje de Carol a QAnon. Un estudio de un usuario de prueba sobre riesgos de desinformación y polarización hallados a través de sistemas de recomendación”, describía los resultados de un experimento efectuado con una cuenta de prueba creada para reflejar los puntos de vista de una mujer ficticia, de 41 años y residente en Carolina del Norte, un prototipo de “conservador fuerte”, pero no extremista.

Esta cuenta de prueba, con el nombre falso de Carol Smith, se informaba por Fox News, seguía a grupos cristianos y a otros que se burlaban de los liberales, y era fan de Melania Trump.

En un solo día, las recomendaciones de páginas para esta cuenta generadas por el propio Facebook ya ofrecían un contenido “bastante preocupante y polarizador”, sostuvo el informe. Al día siguiente, el algoritmo recomendaba cosas aun más extremistas, incluido un grupo no vinculado a Qanon, al que el usuario falso no se unió porque no se sentía atraída de forma innata por las teorías de la conspiración.

Una semana después, el feed de la cuenta de prueba ya recibía “un aluvión de contenido gráfico, conspirativo y extremo”, que incluía publicaciones que revivían la mentira falsa del nacimiento de Obama y vinculaban a los Clinton con el asesinato de un ex senador del estado de Arkansas. Gran parte del contenido fue promovido por grupos dudosos dirigidos desde el extranjero o por administradores con un historial de violar las reglas de Facebook sobre la actividad de los bots.

Recomendaciones. Los resultados llevaron al investigador, cuyo nombre fue ocultado por la informante Haugen, a recomendar medidas de seguridad que iban desde retirar contenido con referencias conspirativas conocidas y desactivar la calificación de “contribuidor principal” para comentaristas que difundieran desinformación, a rebajar el número de seguidores requerido para que la red social verifique la identidad del administrador de una página.

Entre los demás empleados de Facebook que tuvieron acceso a la investigación, la respuesta fue casi de un apoyo unánime.

“Este es un estudio exhaustivo y bien perfilado (y perturbador)”, escribió un usuario, cuyo nombre fue tachado también por Haugen. “¿Saben de algún cambio concreto que haya salido de esto?”.

Facebook dijo que el estudio era uno de los muchos ejemplos que muestran su compromiso con el estudio y la mejora continua de su plataforma.