—Pasó su infancia en la ciudad de Mesilla, a 80 kilómetros de la frontera con México y Ciudad Juárez. ¿Cómo lo influyó la cultura latina?

—Fui a la escuela en Ciudad Juárez de pequeño. Viví allí hasta que mi madre murió. Fui a la escuela en México hasta mis 9 años. Tomaba un pequeño autobús a través del Río Grande cada día. Era algo normal. Solía ser una frontera tranquila. Era una ciudad internacional; la gente cruzaba todo el tiempo. Creo que no podría decir cómo me influyó todo aquello. Soy consciente de que tengo un sentimiento por la estética de América Latina y de México en particular, un amor por el realismo mágico, casi surreal. Siento que eso influyó en mi interés por la realidad virtual. Lo fantástico integrado con la experiencia cotidiana.

—¿La pandemia de Covid-19 fue un acelerador de la masificación del mundo digital?

—Es una pregunta interesante. No sé si tenemos una respuesta todavía. Hasta ahora, veo algunos efectos positivos muy pequeños de la época Covid-19 en internet. Por un lado, ahora es más común que las personas planifiquen tener una vida online: conectarse por videochat, entre otras cosas. Eso significa que no pasan tanto tiempo solo siendo receptores pasivos de lo que les da un algoritmo diseñado para ellos. Sería muy positivo que las personas aprendieran a tener más control de su tiempo y a pensar qué están haciendo. Es posible que internet haya mejorado un poco durante la pandemia. Lo digo casi en broma. Pero trato de ser optimista, quizás demasiado.

—¿Qué es la comunicación postsimbólica?

—Es un tema muy difícil. Si volvemos a los orígenes primitivos de la cultura humana, del lenguaje, del surgimiento de las sociedades humanas, en ese momento descubrimos que podemos usar partes de nosotros mismos, como nuestras lenguas y nuestros dedos, para comunicarnos, para comunicar pensamientos de una variedad mucho mayor a la que podían comunicar otras especies. Lo hacemos a través de lo que llamamos “abstracción”. Hay símbolos y, por tanto, simbolismo. Con pocos sonidos, con un leve movimiento del dedo meñique, los humanos pueden referirse a todo tipo de cosas. Con la realidad virtual, tal vez si nos volvemos lo suficientemente buenos y la virtualidad es suficiente para todos nosotros, podríamos crear experiencias completas en lugar de simplemente referirnos con símbolos. Así que en lugar de tener una palabra que diga “casa”, en realidad se presente una casa. Es lo que empieza a suceder en el mundo online. Los emojis representan de alguna manera eso, de forma incipiente. La cultura de los memes también va en ese sentido. Aunque son primeros pasos, como los de un bebé. La comunicación postsimbólica es una aventura de la comunicación humana.

Como existe la banalidad del mal, también existe la banalidad del cibermal.”

—¿Porque los seres humanos no son computadoras biológicas y no será tan fácil reemplazarlos?

—No hay una respuesta absoluta a preguntas como ¿qué es una computadora? o ¿qué es un ser vivo? Incluso es difícil contestar qué es una persona. Las respuestas habituales tienen un alto contenido de fe. Cuando creemos que otra persona está realmente teniendo experiencias interiores, que otra persona tiene sentimientos reales y es afectada por lo que ocurre, es una cuestión de fe. No sabemos con certeza si el otro es una computadora. Todo ese cúmulo de creencias puede aplicarse a una computadora. Seguramente nos estemos refiriendo a algo hecho por personas, quizás a un producto de una empresa. Quizás también a que depende de la computadora remota de una empresa para operar en la nube. Cuando lo piensas de esa manera, quizás también sea posible la creencia de que una máquina es en realidad una persona, que está realmente viva, que es en realidad como un ser biológico, como una cosa real. Así hay un elemento de poder involucrado en el que estés dando poder a quien construyó esa máquina, al dueño de esa máquina. Hay que tener mucho cuidado, porque es muy posible que la fe se use como una forma de aprovecharse de las personas, como una forma de robo. Una manera de robar su dignidad, su riqueza, su libertad. Me preocupa mucho que la fe en las máquinas sea otra versión del uso de la fe.

—¿Por qué cada dos años se duplica la potencia de un circuito integrado mientras que el software crece mucho más lentamente?

—La ley de Moore dice que el hardware se duplica. Comienza a verse que esa velocidad tiende a disminuir. Nos acercamos al fin de ese proceso. La experiencia explica que todas las curvas que crecen tienden a aplanarse en algún momento, lo que llamamos curva S. Su pregunta aludía a otra cosa: a por qué el hardware evoluciona más rápidamente que el software. Una de las razones es que un sistema de hardware está perfectamente definido. Cada pedacito de un chip está perfectamente definido. Cuando se puede encuadrar un problema con precisión se está en mitad de camino para resolverlo. Como sabemos de qué se trata, es natural que siga mejorando. Pero el software es diferente: es algo abierto. Se conecta con la realidad. Nunca se puede definir a priori perfectamente lo que se supone que debe hacer. Eso significa que el software es más como la cultura. Tiene ambigüedades. El software siempre roza profundas cuestiones filosóficas, estéticas y culturales. Evoluciona, como la cultura. Su proceso definitivamente es más lento. Y así debería ser. Es poco saludable que sea tan rápido.

“Detrás de la idea de inteligencia artificial está la creencia en la mano invisible del mercado.”

—¿Las computadoras del futuro tendrán su propia subjetividad?

—Contestarlo es una cuestión de fe. La subjetividad es algo que experimenta cada uno. La experiencia no es una cuestión directa de fe. Pero la entidad real de otras personas es una cuestión de fe. Consiste en creer que realmente está ahí. No hay una solución lógica a esta pregunta de si alguien más es realmente consciente o no o si la conciencia existe o no en un sentido general, incluso si una máquina puede ser consciente. Es un poco como la cuestión de Dios, o la pregunta sobre el poder. Se trata, en el fondo, de creer. Creer en otras personas. Si no se cree en otras personas, uno se convierte en una mala persona. Uno cree en los demás también por una cuestión pragmática. Pero es peligroso y explotador invertir esa fe en las máquinas. Es un recurso sospechoso de la publicidad de la comunidad tecnológica suponer que hay máquinas vivas. A los dueños de las máquinas les da mucho poder que supongamos que pueden hacer de todo y que son como dioses.

—¿Hay una ideología sobre el futuro de la inteligencia artificial?

—No hay una sola idea sobre la inteligencia artificial. Hay gran variedad de actitudes. Mucha gente influyente tiene lo que llamaría una definición religiosa de la inteligencia artificial. No es solo religiosa; es casi una religión medieval. La creencia de que habrá una computadora gigante en la que podrás subir tu cerebro y vivir para siempre. No es demasiado diferente de la fe medieval en la vida eterna. Es un modelo explotador. Les quita poder a los individuos. Les exige que crean en una corporación o en algunos ingenieros y científicos en lugar de en sí mismos.

—¿Cómo se expresa el totalitarismo cibernético?

—“Cibertotalitarismo” es uno de los términos que utilizo para expresar una ideología en Silicon Valley que incluye inteligencia artificial, pero también otras cosas, como la creencia de que si el mundo es dirigido por nuestros algoritmos, todo mejorará automáticamente. Vemos esa ideología en Facebook, o en las otras empresas que controla como WhatsApp o Instagram. La ideología se refiere a que la gente que está conectada en Facebook hace que el mundo sea mejor. No importa qué. Puede haber pequeñas disrupciones aquí y allá, pero son solo pequeñas excepciones. Lo característico tiene que ser nuestro algoritmo, tiene que ser Facebook. Es una idea muy extraña. Es esta idea de que podemos diseñar algo que sea perfecto para todas las personas y en todas partes en el futuro, y que sea intrínsecamente la solución a todo, es muy peligrosa. Es un ejemplo de cómo incluso las personas muy inteligentes que no podrían ser engañadas pueden hipnotizarse con su propia arrogancia. Me asusta. Y debe asustarnos a todos.

“El software es como la cultura: algo abierto y que está en relación permanente con lo real.”

—Ray Kurzweil, el director de ingeniería de Google, habló recientemente sobre sus planes para comenzar a resucitar digitalmente a su padre ahora muerto. ¿Eso es posible o se trata de otra tecnoutopía?

—Ray articuló esta idea durante muchos años. A nivel personal es complicado, porque se vuelve como una religión. No me siento en condiciones de criticar la religión de otra persona. Ese es el lugar donde se encuentra Ray. El problema es cuando se empieza a vivir en una teocracia, cuando el sistema de creencias de algunas personas poderosas influye en las experiencias cotidianas y las opciones de todos los demás, incluso de aquellos que no creen. Estamos en ese momento histórico. La gente como Ray Kurzweil es un pequeño número. Hay un grupo que tiene una influencia desproporcionada. Obligan a mucha gente a cambiar la forma en que piensan. Obligan a niñas a actuar para agradar a un algoritmo. Ocurre también en Instagram. La forma en que se mueve la cultura es complacer a los algoritmos que, a su vez, miden cuánta gente está influenciada por los anunciantes. Todo este proceso está impulsado por personas como Ray. Google y Facebook manipulan psicológicamente a gran parte de la humanidad usando algoritmos. Se defienden diciendo que son empresas de inteligencia artificial, no de publicidad. Pero son los datos para crear la inteligencia artificial del futuro, que será el nuevo Dios y contendrá todas nuestras conciencias. Creen que están construyendo una gigantesca IA en la que podrán vivir para siempre. Hay algo muy extraño en eso: su ideología fuerza al resto del mundo a un estado en el que la gente tiene que entregar sus datos constantemente. Es un sistema muy perverso. No voy a criticar las creencias personales de Ray Kurzweil Tiene todo el derecho de seguir cualquier fe que encuentre. Pero no tiene derecho a imponer sus ideas a los demás desde una corporación gigante.

—¿El algoritmo cumple el papel de “la mano invisible de Adam Smith”? Se transforma en una ficción que permite renunciar a asumir responsabilidades y poner la excusa de decir “es el algoritmo, no nosotros”.

—No creo que sea del todo cierto decir que la inteligencia artificial es un invento de nuestra era. La mano invisible de Adam Smith, la idea de que el capitalismo de mercado crea este otro tipo de supercriatura que es de alguna manera más sabia que cualquier persona, es la base de la inteligencia artificial. Es casi como un Dios creado, pero un Dios que está casi fuera de control y es un poco inaccesible. Es un Dios que lleva a muchas personas a hacer cosas combinadas por un algoritmo. Antes fue el algoritmo del mercado y ahora son algoritmos de manipulación psicológica operados por las corporaciones gigantes. En muchos sentidos es lo mismo. Economistas como John Maynard Keynes se dieron cuenta de que si se trata al mercado como una especie de individuo, te destruirá. Los mercados fallan, hacen cosas locas. Es necesario contar con regulaciones a ese mercado y con sabios que redacten esas regulaciones. Sin regulaciones, el mercado ya no es una buena herramienta para la humanidad. Con la idea de inteligencia artificial sucede lo mismo.

“Mucha gente influyente tiene lo que llamaría una definición religiosa oscurantista sobre la inteligencia artificial.”

—En su última charla TED dijo que debíamos crear una cultura tecnológica que sea bella, creativa, profunda y que nos aleje de cometer un suicidio en masa. ¿Cómo sería ese suicidio?

—La tecnología nos brinda cada vez más habilidades para encontrar comodidad, longevidad y placer y sentido en la vida. Aprecio mucho sus beneficios. Pero en paralelo, la tecnología puede ser muy destructiva. Lo descubrimos en el siglo XX con las armas nucleares: que podrían destruir a la humanidad, ni más ni menos. A medida que las tecnologías mejoran, hay cada vez más formas que podrían terminar con la humanidad. Ya no es solo una. Podemos acabar con la humanidad destruyendo nuestro clima, con armas biológicas, con la destrucción de nuestro acceso al agua potable y a los alimentos. Son todas alternativas factibles. Y no todas son potestad de los militares. Para que la humanidad no se destruya a sí misma, tenemos que tener algo mejor que hacer. Cuando las personas se aburren, a menudo se vuelven paranoicas. Así, desean experimentar su poder y pueden terminar destruyéndonos. El nuevo deber del arte, de la cultura, es crear aventuras interesantes, suficientemente seductoras y con sentimientos significativos. En una época el arte era algo opcional. Ahora es obligatorio; es la alternativa al suicidio masivo.

—¿Cómo explicaría el mito nietzscheano que la tecnología podía cambiar el universo?

—Si se leen algunas de las memorias de los científicos que participaron en el Proyecto Manhattan (N. de la R.: el desarrollo de científicos norteamericanos e ingleses que devino en las primeras armas nucleares durante la Segunda Guerra Mundial) se ve que describen esta sensación de ser como Superman o algo así: tener el poder de destruir ciudades a partir de ecuaciones matemáticas. Más tarde, Steve Jobs y otros empresarios de Silicon Valley hablaron sobre cómo un empresario tecnológico tiene la habilidad especial como para abollar el universo. La gente común puede vivir en el universo. Pero hay esta manera de cambiar el curso del universo y tener un impacto. Sillicon Valley no es uniforme como pensamiento. También hay muchos hippies pensando en otra cosa. Salir de esas arrogancias no solo es necesario en el Valley. También debemos hacerlo todos para sobrevivir.

“Existe un cibertotalitarismo que cree que el mundo será mejor si es gobernado por algoritmos.”

—Se le atribuye haber creado el término “realidad virtual” hace casi cuatro décadas. Recientemente comparó su surgimiento con la creación del lenguaje para los primeros “Homo sapiens”. Permitió crear un nuevo mundo con toda la posibilidad de imaginar, crear, educar. ¿Sigue pensando que tendrá ese poder?

—Cuando hablaba originalmente de la realidad virtual como algo así como una nueva forma de lenguaje y de la idea postsimbólica de comunicación solo había un pequeño número de sistemas de realidad virtual en el mundo. Tuve la primera empresa que los fabricó comercialmente. Tuvimos los primeros grupos de personas que podían conectarse y comunicarse dentro de ellos. Podrían haber sido solo unas pocas docenas de sistemas en el mundo en total. Nos manejábamos dentro de un mundo de hipótesis. Décadas más tarde, hay decenas de miles de personas con cascos de realidad virtual. Tal vez, incluso, se trata de cientos de miles. Se está volviendo algo más real, aunque todavía es muy temprano para decirlo. Sigo pensando que tiene mucho potencial. En los desarrollos más recientes uno puede ver malas y buenas noticias. La buena noticia es que hay muchos desarrolladores interesados en las ideas originales y están tratando de crear entornos compartidos y se puede crear desde el interior del mundo virtual y todo eso. La mala noticia es que la fuente más prominente de cascos utilizables es probablemente Facebook, que es la compañía con la peor ética y la peor influencia en el futuro entre las tecnológicas.

—Alguna vez habló del libro de Norbert Wiener “El uso humano de los humanos” (“The Human Use of Human Beings”), de 1950. ¿Tienen hoy las tecnológicas como Google y Facebook el poder de modificar y malear la conducta, llegar a ser “imperios de la modificación de la conducta”?

—Es muy difícil de responder con certeza porque no tenemos los datos. Solo tenemos un puñado de datos. Facebook publicó con orgullo una investigación en la que demuestra que pueden hacer sentir triste a un gran número de personas, sin que ellas supieran la causa de esa depresión. Si damos crédito a la propia investigación de Facebook y sus investigadores, deberíamos creer que tienen mucha influencia y poder. Las empresas parecen tener historias diferentes dependiendo de quién suponen que está del otro lado. Cuando una empresa como Google vende sus servicios a los anunciantes es sumamente arrogante: dirá que tiene una extraordinaria capacidad para influir en la gente, como si tuviera el poder de manejar a toda la humanidad. La verdad es menos clara. Pero tenemos pruebas bastante sólidas, incluso de la investigación publicada y revisada por las propias empresas, de que su grado de influencia es peligroso.

“Los memes y emojis representan un nuevo tipo de comunicación humana, postsimbólica; son sus primeros pasos.”

—En el libro “An Essay in Cosmotechnics”, el filósofo chino Yuk Hui escribe que “el algoritmo es la exteriorización del pensamiento racional, que se complica en su proceso de desarrollo desde una lógica lineal hacia una lógica recursiva”. ¿Coincide?

—Es un tema que lleva a una discusión compleja, porque la naturaleza de los algoritmos cambió mucho en los últimos años. Solía escribirse el algoritmo con alguna intencionalidad. Pero incluso entonces se podría argumentar que tal vez no lo hicimos, o no estábamos tan en control o comprensión de nuestros algoritmos como pensamos. Pero más recientemente los algoritmos se diseñan para que tengan bucles de retroalimentación y comiencen a cambiarse y adaptarse de acuerdo a algunas señales. En el caso de las empresas de redes sociales como Google y YouTube en la búsqueda y todas las compañías de Facebook como WhatsApp y demás, lo que vemos es que los algoritmos se están ajustando de acuerdo a cómo pueden captar y mantener la atención y luego cuánto pueden cambiar el comportamiento de las personas y sus intereses y puntos de vista. Sucede que una de las cosas muy extrañas es que incluso las personas que escriben los algoritmos no están del todo seguras de por qué funcionan o qué hacen o cómo funcionan exactamente. Comenzamos a entender las matemáticas de lo que se convierte en un mejor aprendizaje. Pero en la práctica, todavía hay poca calidad de caja negra. Configuramos esta caja negra que se supone que se adapta de acuerdo a alguna señal y luego comienza a funcionar, pero no estamos muy seguros de por qué. Poco a poco están dejando de ser racionales, en el sentido de que no están basados en el pensamiento humano sistemático o la intención. La discusión se vuelve más sutil.

—Yuk Hui cita a Heidegger: “Cualquier salvación que no provenga del peligro se encuentra aún dentro del desastre”, y concluye que “estamos siendo llevados por la gigantesca fuerza de la tecnología hacia ninguna parte, y si no tratamos de entenderla y transformarla ahora, tendremos que estar preparados para la constante llegada de catástrofes”.

—Esto me suena bien. Mi respuesta es sí. Es muy razonable pensar que estamos siendo llevados a ninguna parte.

—El filósofo Giorgio Agamben en su texto “¿Qué es un dispositivo?” (2011) sostiene: “Aquí radica la vanidad del bienintencionado discurso sobre la tecnología, que afirma que los aparatos pueden reducirse a la cuestión del uso correcto. Aquellos que hacen tales afirmaciones parecen ignorar un hecho simple: si un cierto proceso de subjetivación (o en este caso de “desubjetivación”) corresponde a cada aparato, entonces es imposible que el sujeto de un aparato lo use de la manera correcta”. ¿Está de acuerdo?

—Diría que sí. El concepto de dispositivo conlleva una ontología en la que se pueden separar las prácticas generales en pequeñas piezas. Es una forma de tratar de centrar la tecnología en sustantivos en lugar de verbos. Los sustantivos no tienen significado sin contexto y sin verbos. Por tanto, la declaración es bastante correcta. La idea del dispositivo también sugiere una forma económica de pensar en la tecnología. Los sustantivos, las pequeñas piezas, son las cosas que compramos, vendemos y poseemos.

“No sabemos con certeza si el otro es una computadora; tenemos fe en que no lo es.”

—En su texto “Maoísmo digital: los peligros del nuevo colectivismo en línea”, usted criticó la omnisciencia que a veces se le atribuye a la sabiduría colectiva. Por ejemplo, en el caso de Wikipedia, usted escribió en 2006: “Si comenzamos a creer que internet es una entidad que tiene algo que decir, estamos devaluando a la gente [que crea el contenido] y nos convertimos en idiotas”. ¿Cambió algo en estos 15 años esa forma de ignorancia?

—Lo que hace la inteligencia artificial es tomar datos de la gente y enmascararlos para que parezcan venir de algún ángel de propiedad corporativa y usarlos para influir en esas personas. Es una especie de juego en el que estás eliminando la acción humana. Esto también tiene un impacto económico. Si se cree que el colectivo es esta criatura expresada a través de algoritmos de IA, en el futuro habrá un momento en que en su lugar, en vez de un periodista, haya un robot que se siente allí y formule tres preguntas. En ese momento, se dirá que ese robot tiene un dueño. Pero el robot solo puede existir por todos los datos de las personas. Debe entenderse como una nueva forma de colaboración. Entonces habría una posibilidad de que la gente ganara dinero por haber contribuido al comportamiento del robot. Si se tomara esa premisa, puede concebirse un futuro de empleo en el que se reconozca el valor de esa colaboración. La idea de fingir que las personas no existen, agrupándolas en un colectivo, es una forma de desempoderarlas y centralizar el poder altamente disfuncional.

—Se refirió a Wikipedia como ejemplo de forma ideal de funcionamiento de internet. Sin embargo, en Argentina fue secuestrada ideológicamente, perpetuando la desfiguración de los perfiles de un grupo partidario en particular, mientras se protegen los del otro.

—Eso es muy interesante. Después de que escribí mi crítica a Wikipedia, un buen número de años atrás, los fundadores la apoyaron públicamente. En cierto modo, es un poco difícil criticar Wikipedia en este momento tanto como se debería, porque a su vez se aprovecharon de Wikipedia. Si nos fijamos en el auge de Google, las búsquedas no existirían sin Wikipedia. Wikipedia es una organización pública voluntaria que siempre está hambrienta. Y Google se ha convertido en esta increíble fuente gigante de riqueza y control de poder por un pequeño número de personas. Visto así, uno puede sentir hasta pena por Wikipedia. Uno piensa que debería haber tenido mejor suerte. Ambas cosas son ciertas. Wikipedia promueve una sensibilidad del mundo que es realmente dañina, crea la ilusión de que se puede hablar sin un punto de vista. Crea la ilusión de que puede haber una sola verdad sobre un tema, que debería haber solo una enciclopedia en lugar de múltiples. Pero también es justo defenderla porque fue muy explotada. Es lo que sucede con una mala ideología. Se crea una cadena de explotación con muchas víctimas. Es un tema que no puede explicarse en términos de buenos y malos.

“Personas inteligentes también pueden caer en el hipnotismo de la propia arrogancia; Facebook es el ejemplo.”

—Refiriéndose al colectivismo digital escribió: “¿Qué va a impedir que una masa en línea de personas anónimas pero conectadas se convierta en una turba, como lo han hecho las masas una y otra vez en la historia de toda cultura humana?” ¿La búsqueda de información más profunda requerirá encontrar información con firma que la avale y revalorizará en el futuro la tarea del periodismo profesional?

—Escribí el ensayo Digital Now alrededor del momento de cambio de siglo. Por ese entonces, recibí muchas críticas. La gente me acusó de exagerar y prever catástrofes. Es un tema que abordé antes, a principios de los 90. Escribí que los bots agentes, los programas automáticos, podrían crear ilusiones online que podrían lanzar elecciones y destruir democracias. Esta ideología no es la de Silicon Valley. Es una ideología no compatible con la democracia. Me entristece saber que tuve razón. Cuando se hace una predicción pesimista, cuando se dice algo que suena horrible, lo que se desea es estar equivocado. Uno alerta para que los demás no hagan algo malo. Sería bueno que actúen esas alarmas y quedar como un tonto. Pero este no es el caso: hubo una irrupción de una mafia online. Lo llamé maoísmo digital porque quería señalar que este fenómeno del maoísmo irracional no es nuevo para la humanidad. Sucede periódicamente en todas partes. Lo nuevo es su generalización y universalización. Es diferente con la llegada de Facebook. Una política paranoica en manos de autócratas infantiles que se apoderan de todas partes a la vez. Es horrible y muy peligroso. Es un problema que enfrentan la mayoría de los países grandes y medianos. En los Estados Unidos tenemos extraños cultos paranoicos online arruinando nuestra política basados en fantasías y pensamientos ridículos.

—Escribió el libro “Contra el rebaño digital. Un manifiesto” (2010). ¿Le sorprende que Google y Facebook concentren el 80% de los ingresos de publicidad mundial sin que se hayan tomado medidas regulatorias antitrust en los Estados Unidos?

—Me está haciendo preguntas deprimentes. Google y Facebook, especialmente esta última, fueron grandes decepciones. Con Facebook es interesante ver la salida de los primeros fundadores o de los inversores que renuncian a ella como algo horrible. Tanto que es difícil hacer seguimiento. Incluso quienes trabajan ahí reconocen que es horrible. Hay cierto estigma social para quienes trabajan en Facebook. Algo similar cabe para Google. Tengo esperanza en un cambio intrínseco de la realidad. No sé si la solución de este tema pasa por una ley antimonopolios. Se empiezan a activar regulaciones en diferentes lugares. Lo vemos especialmente en Australia y en Europa. La regulación antimonopolio en Estados Unidos tiene una extraña cualidad. Muchos son políticos que no estarían en el poder sin el tipo de energía que Facebook les otorga. Les produce mal humor no recibir apoyo de Facebook. Para ser útil, una ley antimonopólica debe ser auténtica.

“La cultura busca complacer a algoritmos que miden cuánta gente está influenciada por los anunciantes.”

—Dice que compañías como Google y Facebook se están convirtiendo en máquinas de manipulación del comportamiento, pero hay muchos que cuestionan esa capacidad para influir en una elección.

—Son fenómenos a gran escala y no tenemos acceso a todos los datos. Mi sospecha es que si Facebook no existiera, habría habido un presidente diferente en varios países. Probablemente Brasil tendría un presidente diferente. Los Estados Unidos también. En otros casos, tenemos más incertidumbre, pero también quizás sea así.

—Google y Facebook nacieron sin avisos: ¿el punto de inflexión fue la publicidad y la búsqueda de maximizar la audiencia?

—Conozco más lo que pasó con Google porque orbité su universo. Mis amigos y yo les vendimos una empresa cuando empezaban. Google comenzó muy lindo, optimista y joven. Generaba una buena emoción en los primeros días. El modelo de negocio publicitario los puso en un camino del que nunca podrían salir, que los tornó cada vez más oscuros y dañinos para el mundo. Es una suerte de tragedia de la que casi es imposible salir. Son víctimas de sí mismos. Entraron en esa senda entre otras cosas porque gran parte de la cultura de la piratería, de la programación informática de ese momento, les dejó campo. Los programadores querían que el mundo online no tuviera dinero ni propiedad. Por eso mismo, odiaban la idea de los derechos de autor. Se suponía que todo era abierto y libre y todo debería compartirse. Y así se abría la posibilidad de compartir para mucha gente. Pero la compañía todavía quería ganar mucho dinero, querían seguir los pasos de Steve Jobs. La idea era que Google fuera gratis, pero luego ganaría dinero de los anunciantes. Con ese criterio, los usuarios ya no serían los clientes. Y así, los usuarios se convirtieron en el producto, no en los clientes. Así nació este mundo oculto en el que las decisiones reales y el dinero real y el poder real y la motivación real eran sobre la influencia y la persuasión. Todo bajo la ilusión de un pueblo Potemkin, una especie de paraíso socialista en el que todo se comparte. Y todo fue una mentira, pero una mentira de la que no queda otra opción que participar. Si hubieran querido cobrar por búsqueda, hubieran sido rechazados por los socialistas de Silicon Valley. Y si no se hubieran convertido en multimillonarios, también serían rechazados por la cultura de Silicon Valley. No tuvieron otra elección. Fueron empujados a este embudo del mal. Es una tragedia humana porque creo que serían historias diferentes con Facebook. En el caso de Google fueron una especie de jóvenes bienintencionados y positivos absorbidos por un plan que realmente los convirtió en gente malvada.

—Se refirió a ellos no como gente mala, sino como un error estratégico global. ¿Puede ser que ese error haya crecido sin corrección porque se convirtió en una herramienta de control para los servicios de inteligencia, de seguridad y militares de las principales potencias?

—Otra pregunta interesante. Observé a Mark Zuckerberg a lo largo de los años y algunas cifras. Tal vez haya personas que no estén listas para exonerarlo. Sigo sintiendo que los fundadores de Google eran buenos chicos que se metieron en un mal esquema. En lo que respecta a los militares, la historia es complicada. Los militares de Occidente que siguen la actividad de internet y las redes sociales no parecen muy competentes. Cuando Google o Facebook ejecutan los algoritmos e influyen en la gente ellos saben lo que están generando sus efectos. No estoy seguro de que las personas que Edward Snowden expuso tengan esa competencia. De todos modos, esta historia también es más compleja porque, desde que escribí sobre esto, además de las grandes empresas estadounidenses se levantaron las compañías chinas. Y las empresas chinas sí son significativas. Nacieron desde un principio con una idea de conexión estatal y control estatal de una manera muy diferente. Ahora no solo podemos hablar del capitalismo norteamericano o de las empresas alemanas. Tenemos que hablar de los chinos. Usan las mismas herramientas, pero son diferentes. Utilizan muchos algoritmos similares, diseños similares, experiencias de usuario similares. Tal vez sean más competentes en algunos aspectos, aunque a veces cuando miro lo que hacen los chinos me parece demasiado simple y tal vez un poco ingenuo. Además, la forma en que lo hacen los chinos es tan intensiva en mano de obra que no puede escalar. Como decimos, tienen un gran número de personas que pasan por los puestos de otras personas. La tragedia de lo que está pasando es que tenemos sociedades dañadas. Esto no se debe únicamente a un mal esquema. Hay más esquemas patéticos, poco operativos y estúpidos. Así como existe la banalidad del mal, existe la banalidad del cibermal. No hay que ponerse paranoicos y pensar que hay un supervillano remoto detrás de todo.

Facebook publicó con orgullo la investigación que demuestra que pueden hacer sentir triste a la gente.”

—¿Facebook y Google y sus análogos chinos se convierten en agencias de espionaje?

—Sí. Hay, por supuesto, agencias de espionaje. No hay duda de que crearon un estado de vigilancia. Dada la amplitud de referencias que trajo a nuestra charla, pienso en el diseño de la prisión panóptica de Jeremy Bentham en la que hay un espacio central en una prisión circular para que un pequeño número de guardias puedan mirar a todos los prisioneros a la vez. Esto no es un panóptico o, más bien, es un panóptico incompetente. No se trata de un mal sistema bien diseñado. Es un sistema estúpidamente diseñado y disfuncional. Pone a todos los individuos en la prisión bajo vigilancia y los hace sentir un poco locos y paranoicos. Y tampoco tiene una dirección. No debemos pensar que detrás de esto hay una mente maestra brillante y maligna.

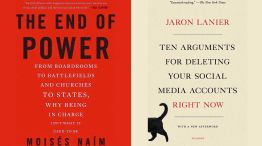

—En su texto “Diez argumentos para borrar tus redes sociales ahora mismo”, escribió: “Evito las redes por la misma razón que evité las drogas: me hacen mal”.

—Está demostrado que hay ciertas cosas que pueden hacerte sentir bien por un momento, pero con el tiempo te hacen peor. Una de esas cosas es la adicción a las drogas químicas. Las investigaciones disponibles muestran que la adicción a las redes sociales tiene la misma cualidad. Existen pequeños conductores psicológicos. Si alguien se siente solo, puede ayudar un poco. Pero en general te tira hacia abajo y luego más hacia abajo. Poco a poco te hace sentir paranoico. Te hace más irritable. Te hace un poco menos racional, menos capaz de percibir la realidad con precisión. Solo daña a las personas. Debo decir que esto es estadístico. Esto es lo que suele suceder, aunque podría haber individuos para quienes eso funciona muy bien. En mi libro reitero que no hablo de personas en particular, sino que me refiero al panorama estadístico en general. Las redes dañan a la gente. No conozco a ningún investigador que niegue este punto. Y una de las cosas que digo en el libro una y otra vez es que no te conozco y no puedo caracterizar o diagnosticar o comentar tu vida en particular y tus experiencias particulares, obviamente. Y doy gracias a Dios por eso. Pero podemos hablar del panorama general estadístico. Y estadísticamente sí, daña a la gente. No conozco a ningún investigador sincero que dude de esto en este punto.

“Wikipedia crea la ilusión de que puede haber una sola verdad sobre un tema.”

—¿En qué medida las redes sociales propician un aumento del tribalismo en vez de un crecimiento de la democracia?

—Los algoritmos te están observando, pero de maneras muy inadecuadas. El algoritmo puede decir cuándo hace click en algo. Últimamente, los más sofisticados son capaces de hacer un seguimiento de dónde estás buscando si usás un smartphone más nuevo. Tienen varias señales. Entonces, quieren saber cómo hacen para mantener tu atención, para hacerte hacer click en cosas en las que no lo habrías hecho de acuerdo a tus estadísticas previas. Buscan saber tu compromiso y la capacidad de persuasión. El problema es que en el cerebro humano hay ciertos circuitos que son un poco más fáciles de involucrar que otros. Llamamos a estas cosas las respuestas para luchar o huir. Cuando se tiene miedo, el cerebro decide si luchar o huir. Esas respuestas están cableadas. Son más profundas que la humanidad. Son instintivas. Los algoritmos pueden detectar más fácilmente esos mecanismos. El truco es que se tienen algoritmos optimizados automáticamente para obtener una respuesta de la gente. Un ejemplo se da en los Estados Unidos con el movimiento de protesta Black Lives Matter, a partir de los tiroteos policiales contra jóvenes negros. La primera ola de Black Lives Matter consiguió un increíble impulso en las redes sociales, donde pudieron organizarse y sacar su mensaje. Fue casi como un viaje en alfombra mágica, pero los algoritmos están enviando contenido de Black Lives Matter para averiguar quién responderá más. Y la gente que responde más son las personas que temen o están enfadadas por ello. Por lo tanto, los algoritmos encontraron a todas las personas racistas, del viejo Ku Klux Klan. Se introdujo a esas personas ese contenido con el fin de excitarlas cada vez más. Eso sucede automáticamente. Así es como nace este movimiento racista organizado a gran escala supremacista blanco en los Estados Unidos que no existía antes. La gente estaba allí, pero no estaba organizada. No se conocía. Así que este algoritmo, naturalmente, porque busca la respuesta de luchar o huir, encuentra a las personas que están asustadas o enojadas sobre el contenido de otras personas. Eso es lo que hay en las redes. Estos sistemas fomentan naturalmente las divisiones en la sociedad. Hacen que la gente desconfíe entre sí. Crean más de un tribalismo que estaba en la naturaleza humana. Pero que los algoritmos empeoran.

“Keynes se dio cuenta de que si se trata al mercado como una especie de individuo, te destruirá.”

—Como lleva más tiempo construir amor que destruir amor, ¿la manipulación del “like” y “no like” construye una sociedad donde impera lo negativo y esto se percibe en el crecimiento de líderes polarizantes, paranoicos, cínicos y hasta nihilistas que afectan a la democracia?

—Los políticos sinceros y competentes en el mundo deben nadar aguas arriba. Tienen que luchar contra el flujo de estupidez y negatividad que viene de internet. Eso no significa que no puedan tener éxito. Simplemente lo hace más difícil. En todo el mundo cada vez que hay alguien que tiene el potencial de ser competente, no cínico o corrupto, se enfrenta a un creciente desafío de desinformación o simplemente de basura y con personas enojadas irracionalmente. Esas cosas se generan algorítmicamente para crear un beneficio. Es un gran inconveniente. Un problema que puede terminar con nuestra especie. Esperemos que la humanidad aprenda un poco. En general, la gente está aprendiendo a ser un poco más cuidadosa con estas cosas. Tal vez allí exista un camino.

—Dijo que “nuestra especie no podrá sobrevivir en un mundo en el que para que dos personas quieran comunicarse haya una tercera en el medio que desee manipularlas”. ¿Para solucionar el problema no deberían intervenir los Estados con leyes antitrust como se hizo con las empresas telefónicas a finales del siglo pasado y antes con las industriales a principio de siglo pasado?

—Debería haber acciones regulatorias. La cuestión es si la defensa de la competencia es la acción correcta. Podría ser. Tengo un amigo llamado Tim Wu en los Estados Unidos. Trabajó muchísimo para presentar argumentos a favor de la ley antimonopolio. Como mencioné anteriormente, parte de la acción antimonopolio en los Estados Unidos está impulsada por personas que esencialmente quieren que Facebook sea más sesgada hacia ellos. Hasta donde puedo decir. Hay una falta de pureza en la motivación para la antimonopolio, al menos si nos guiamos por declaraciones públicas. Y eso es preocupante. Si se convirtiera a Facebook en cuatro compañías en lugar de una, no cambiaría mucho el mundo si no cambian su sistema. Se podrá haber logrado algo para crear más y más competencia en el negocio de la publicidad, tal vez. Pero no se habrá hecho nada para mejorar los problemas realmente graves. Deberíamos considerar otros tipos de regulación. Estoy particularmente interesado en los derechos de datos. Si decimos que los datos provienen de alguien son creaciones de quien los hace. Rige lo mismo que para una canción o un libro. Hay derechos sobre ellos. Eso nunca puede ser cortado y deben tener derecho a negociar cómo se utilizan los datos. Deben ser capaces de hacer que los representantes exijan dinero o rechacen ciertos usos. Eso distribuiría el poder. Podría ser una forma más eficaz de regular y podría hacer crecer la economía, porque significaría que más de la economía productiva quedaría reflejada en lugar de ocultarse. Como dicen los economistas, podría proporcionar una estructura dentro de las sociedades de mercado para regular el uso indebido de esos datos. Eso otorgaría a la gente el orgullo de contribuir, en lugar de sentirse constantemente como apéndices inútiles de las grandes compañías. Tanto una como otra son herramientas.

“Los militares que siguen la actividad de internet y las redes sociales no parecen muy competentes.”

—¿El futuro de la mejor parte de la web y las redes sociales surgirá pagando por los servicios que dan, tal como sucedió con los diarios y revistas del siglo XIX que se mantenían con lo que pagaba el lector al comprarlos?

—Aunque no es una regla, aumenta la calidad de los productos que no se financian solo con publicidad. No sucedió exactamente así con la radio y la televisión. Fue cierto para los periódicos y las publicaciones periódicas. No creo que la publicidad sea siempre mala. Sí la publicidad personalizada es probablemente siempre malvada. La publicidad convencional ayudó a la gente a adaptarse a la modernidad. Contribuyó a obtener poder y hábitos. La modernidad fue buena para la gente. No la condeno en su conjunto. Pero la publicidad como único negocio, que es el caso de Google y Facebook, sí crea degradación. Hace que toda la sociedad se pregunte quién puede rastrear a quién en lugar de ayudarnos unos a otros, que es lo que la economía debería fomentar. Lo que tiene que bajar es el porcentaje publicitario. Está demostrado que, si puede hacerlo, la gente está dispuesta a pagar por cosas. Lo hacen para Netflix. Por supuesto, si arruinamos la economía del mundo lo suficiente, nadie pagará nada. Y con el pago sube la calidad. Así, la idea de pagar por el contenido es, dentro de una economía de mercado, una idea con mucha cordura. De lo contrario no habrá nada más que manipulación.

“No sé si el tema de Facebook y Google se resuelve con una ley antimonopolio.”

—Lo escuché dar el ejemplo del conductismo en animales, a través de premios y castigos, como trasladable a humanos. ¿Son las redes sociales una forma de laboratorio de estímulo-respuesta que le gustaría a Iván Pavlov, el célebre premio Nobel de Medicina de 1903?

—Históricamente, un conductista posterior después de Pavlov fue Burrhus Frederic Skinner. Fue el primero en diseñar una experiencia para humanos usando computadoras en una red digital. Una red digital antes de internet, de principios de los 60, en el centro de los Estados Unidos. Tenía la idea de que podría implementar un esquema de comportamiento. Exactamente lo contrario de Norbert Wiener. Creía que sería mejor tener a la gente bajo control que en completa libertad. No estoy de acuerdo con él. Se necesita tener gente real. Hay personas que realmente se están inventando a sí mismas para tener una sociedad creativa y avanzada que pueda lidiar con la modernidad. No creo que funcione tener personas bajo control central. Es un debate antiguo que se remonta hasta Platón. Mucha de la actual ideología china en internet tiene un poco de ese carácter. El control de la gente es la cuestión filosófica fundamental. Si se cree que la gente es libre de inventarse a sí misma, hay más posibilidades de propagar la humanidad que cuando las personas están bajo control. De alguna manera, también es cuestión de fe. Es la fe a la que adhiero.

—¿En su origen internet tenía una misión socialista de izquierda? ¿Cuándo y cómo se torció ese rumbo?

—La descripción de la red digital se remonta a 1907 y a una novela llamada The Machine Stops, de E.M. Forster. Describe aproximadamente lo que pasa. Describe un sistema manipulador y deshumanizador que no funciona para las personas. El primero que se elaboró con cierto detalle fue el trabajo de Tim Nelson en la década de 1960 llamado Z2. Nunca se aplicó plenamente, pero tenía un núcleo humanista idealista en el que no se controlaría a las personas. Si Skinner trabajaba en eso, mencioné que eso implicaba controlar a la gente. Internet generalmente se refiere a una forma técnica particular de crear redes, que se denomina conmutación de paquetes. Y eso comenzó en un proyecto financiado por militares. Y esa era una especie no ideológica. En su origen fue algo particularmente abstracto. Las primeras versiones de conmutación de paquetes eran muy exclusivas, la gente tenía su propio tipo de dominios, que no se conectaban entre sí. Fue más tarde y con un poco de dinero de soborno del gobierno que empezaron a interoperar y que se convirtió en internet. No tuvo detrás una especie de ideología libertaria. Diría que se trataba socialmente de crear negocios. Tal vez se trató de un error en retrospectiva.

“Incluso quienes escriben los algoritmos no tienen conciencia total de cómo funcionan.”

—El título de uno de sus últimos libros es “¿Quién controla el futuro?” (2012). ¿Quién lo controla?

—El futuro es propiedad de las personas que poseen, comprenden y controlan sus datos. Si todo el mundo posee y controla sus propios datos, será democrático, creativo y social. En cambio, si solo un pequeño número de personas poseen, controlan y entienden los datos, el futuro es autoritario.