“En medio de la revolución industrial británica, los luditas protestaron por el impacto de la rápida adopción tecnológica en detrimento de los trabajadores artesanos saboteando la maquinaria de las fábricas. Destrozaron telares, atascaron motores y, en casos extremos, quemaron fábricas enteras. Hoy en día, la inteligencia artificial plantea una amenaza similar a los trabajos creativos. Las empresas de tecnología, quizás nietas digitales de los industriales victorianos, construyen modelos de aprendizaje automático eliminando el trabajo de los artistas sin consentimiento ni compensación. Está surgiendo un movimiento de resistencia, aunque sus miembros están armados con inteligencia de codificación en lugar de la intervención física directa”.

Este párrafo de Richard Whiddington en Artnet News ilustra la problemática contemporánea, el conflicto que enfrentan los artistas (o creadores culturales) de todos los rubros (artes plásticas, cine, música, fotografía, libros, etc.): la inteligencia artificial (IA) generativa aprende de todo lo existente sin reconocer ni pagar derechos de autor. Esto ocurre con la mayoría de los servicios ofrecidos por las grandes empresas de tecnología. En diciembre pasado, por ejemplo, el New York Times demandó a Microsoft y OpenAI por utilizar sus artículos sin autorización para entrenar a ChatGPT. También ocurrieron presentaciones conjuntas de artistas norteamericanos que, hasta ahora, no han tenido fallos favorables. Es que el vacío legal de esta actividad resulta campo propicio para que las IA sigan aprendiendo sin pagar derechos de uso, a la vez que venden su servicio a los usuarios reciclando el material analizado y clasificado en sus archivos de memoria.

La IA generativa imita los estilos de los artistas, produciendo una serie de resultados perjudiciales que no son perceptibles al público en general. La copia intencional de los estilos no solo provoca pérdidas en comisiones e ingresos básicos, sino que la multiplicación de copias sintéticas de baja calidad diluyen la marca y reputación de los artistas: ocurre que cada estilo, su singularidad, configura la identidad. Que el estilo artístico forjado durante años se utilice para crear contenido sin consentimiento o compensación lo sitúan en un delito comparable con el robo de identidad.

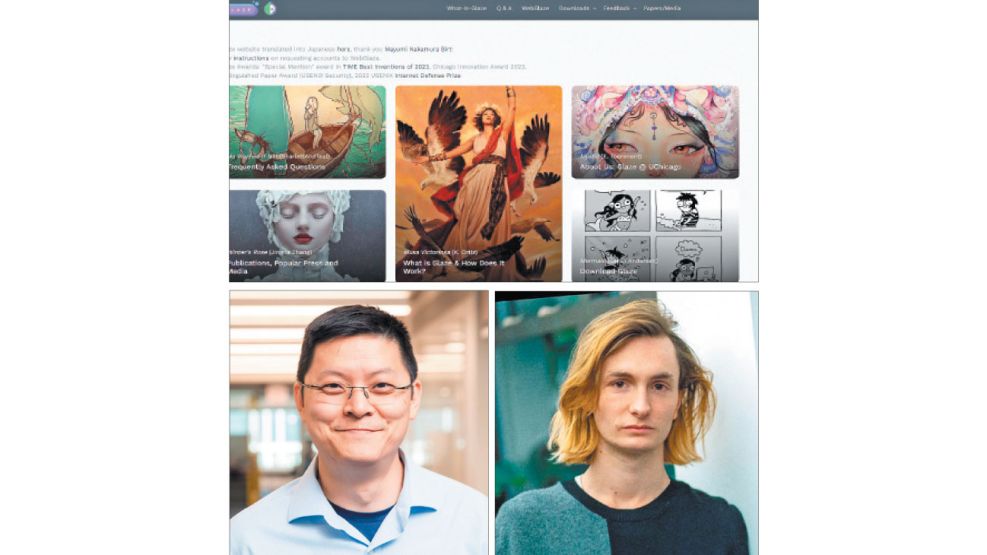

Por estos motivos, centrados en la generación de imágenes no animadas, un grupo de investigadores de la Universidad de Chicago, bajo la dirección del profesor Ben Zhao, desarrolló dos sistemas para proteger la originalidad de las obras artísticas. El primero, Glaze, protege el estilo; el segundo, Nightshade, interviene en la intrusión para el aprendizaje de las IA generativas. Ambos, por ahora, con efectos nocivos para sistemas como Midjourney, Stable Difussion, DALL-E, el ya mencionado ChatGPT y muchos otros.

Glaze está diseñado para proteger a los artistas humanos interrumpiendo la imitación de estilos. Trabaja entendiendo cómo los modelos de IA se entrenan con en el arte humano y, usando algoritmos de aprendizaje automático, calcula un conjunto de cambios mínimos en las obras de arte de modo que parezcan sin cambios a los ojos humanos, pero no así para los modelos de IA que interpretarán un estilo artístico totalmente diferente.

Entonces, los ojos humanos pueden encontrar un retrato en carbonilla vidriado con un estilo realista sin cambios, pero un modelo de IA podría ver la versión vidriada como un estilo abstracto moderno, al estilo de Jackson Pollock. Por lo tanto, cuando alguien le pide al modelo que genere arte imitando al artista en carbonilla, obtendrá algo bastante diferente de lo esperado.

Nightshade funciona de manera similar a Glaze, pero en lugar de una defensa contra la imitación de estilos, está diseñado como herramienta ofensiva capaz de distorsionar las representaciones características en los modelos de imágenes generativas de IA. Al igual que Glaze, Nightshade calcula una optimización multiobjetivo que minimiza los cambios visibles en la imagen original. Así, mientras que los ojos humanos ven una imagen intervenida que prácticamente no ha cambiado respecto a la original, el modelo de IA ve una composición diferente.

Por ejemplo, los ojos humanos podrían ver una imagen intervenida de una vaca en un campo verde prácticamente sin cambios, pero un modelo de IA podría ver un gran bolso de cuero tirado en la hierba. Entrenado con un número suficiente de imágenes intervenidas que incluyen una vaca, la IA generativa estará cada vez más convencida de que las vacas tienen bonitas asas de cuero marrón y bolsillos laterales lisos con cremallera. Es decir, la IA enloquece.

Tanto Glaze como Nightshade se pueden descargar gratuitamente. El primero, incluso, brinda el servicio de intervención y enmascaramiento de imágenes de forma online. Durante enero, en los primeros cinco días desde su lanzamiento, Nightshade recibió 250 mil descargas. Se calcula que la comunidad de artistas norteamericanos superan los 2,3 millones. Un ataque conjunto a las IA con imágenes contaminadas detendrá el aprendizaje por los resultados ilógicos, como pedir por la foto de un gato de angora obteniendo un perro salchicha con tres orejas.

La contaminación de las IA puede tener como respuesta contramedidas: nuevos algoritmos de las empresas que detecten el mal y lo eludan. Pero a eso seguirá un contrataque. Estamos, por lo visto, en una batalla sobre un mar de datos (imágenes) donde los luditas de hace más de cien años regresan para forzar una nueva negociación, ya no por un puesto de trabajo o un sueldo digno, sino para que no les roben con descaro.